Data Driven Services

Data Driven Services: Erfolgreiche Entscheidungen durch Datenanalyse

Data Driven Services, also dienstleistungen, die auf Datenanalyse basieren, spielen heute eine entscheidende Rolle für den Erfolg von Unternehmen. In einer Welt, in der der digitale Wandel unaufhaltsam voranschreitet, ermöglichen datenbasierte Entscheidungen es Unternehmen, ihre Produkte zu verbessern und neue Kundengruppen zu gewinnen. Der Schlüssel zu diesem Erfolg liegt in einer effizienten Datenlandschaft, die es erlaubt, wertvolle Erkenntnisse aus vorhandenen Daten zu ziehen.

Eine umfassende Datenstrategie, kombiniert mit einer effizienten Datenintegration, ist hierfür unerlässlich. Unternehmen, die unterschiedliche Datenquellen intelligent zusammenführen, legen das Fundament für neue Einblicke. Dazu gehört die Sicherstellung der Datenverfügbarkeit, die Steigerung der Daten- und Prozessqualität sowie die Anpassung der Dateninfrastruktur an unterschiedliche Anforderungen.

Der Einsatz von fortgeschrittenen Analysemethoden und Machine Learning ermöglicht es Unternehmen, zukunftsorientierte Prognosen zu erstellen. Der Einsatz künstlicher Intelligenz und moderner Technologien zur Verarbeitung großer Datenmengen spielt dabei eine zentrale Rolle. Automatisierte und optimierte Entscheidungsprozesse führen zu effektiveren und präziseren datengetriebenen Entscheidungen. Diese sind die Grundlage für die Entwicklung innovativer Services und Geschäftsmodelle, die entscheidende Wettbewerbsvorteile schaffen.

Zudem sind passende Methoden und Tools zur Datenvisualisierung unverzichtbar, um Daten klar und ansprechend darzustellen. Mit bewährten Methoden, Tool-Empfehlungen und Vergleichen aus verschiedenen Branchen macht dieser Ansatz das Konzept der Data Driven Services praxisnah und verständlich.

Durch kontinuierliche Innovation und Anpassung im Bereich der Data Driven Services stärken Unternehmen ihre Marktposition in einer immer digitaler werdenden Welt und können effizient auf neue Marktopportunitäten und Herausforderungen reagieren.

Auf dem doubleSlash-Blog finden Sie eine umfassende Sammlung von Artikeln zu Data Driven Services. Diese Artikel sind ideal für jeden, der sich mit datengetriebenen Entscheidungen und deren Anwendung in der Geschäftswelt beschäftigen möchte.

Road to Dashboards: Datenintegration

13.03.2024 –

Wie entstehen Dashboards und welche Bausteine sind dafür unerlässlich?

weiterlesenDos & Don’ts der Datenvisualisierung

14.02.2024 –

In einer Welt, die von Daten überflutet wird, ist die Kunst der Datenvisualisierung entscheidender denn je. Richtig eingesetzt, kann sie komplexe Informationen zugänglich und verständlich machen. Doch nicht jede Visualisierung erreicht ihr Ziel – manche klären auf, andere verwirren.

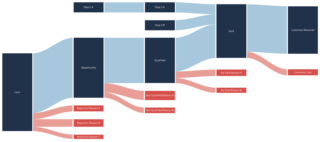

weiterlesenVisualisierung von Datenflüssen

17.01.2024 –

Die Darstellung von Datenflüssen bringt Klarheit und Tiefe in die Welt der Datenvisualisierung.

weiterlesenEin Jahr ChatGPT – Eine Bestandsaufnahme

10.01.2024 –

Wir werfen einen Blick auf die erstaunlichen Fortschritte, die dieser KI-Chatbot in nur einem Jahr gemacht hat.

weiterlesenChatGPT mit eigenen Daten nutzen: Eine Einführung in RAG-Chatbots

06.12.2023 –

Seit seiner Veröffentlichung Ende 2022 hat ChatGPT die Künstliche Intelligenz in den Mittelpunkt der Gesellschaft katapultiert.

weiterlesen