Beiträge von Markus Beller

Car Connectivity Consortium (CCC) Plugfest Palo Alto – den Digital Key Standard praktisch auf die Probe gestellt

20.12.2023 –

Wir waren Teil des CCC Plugfestes in Palo Alto vom 11. bis 15. Dezember 2023 im Herzen des Silicon Valley – mit unserem Digital Key Produkt. Der Ausrichter war in diesem Falle der amerikanische Fahrzeughersteller Rivian. Hier berichten wir von unseren Erfahrungen.

weiterlesenPersonalisierte Dienste revolutionieren die Mobilität der Zukunft

29.11.2023 –

Softwaregetriebene und personalisierte Anwendungen bestimmen zunehmend den Nutzwert unserer Autos. Damit einher geht ein grundlegender Wandel: Leistungsmerkmale und Dienste sind bald nicht mehr an die Hardware gebunden, sondern an die Personen, die sie nutzen.

weiterlesenBeeinflusst ein Tempolimit die Entwicklung autonomer Fahrfunktionen?

25.10.2023 –

In den vorherigen Beiträgen haben wir uns intensiv mit dem Tempolimit auseinandergesetzt.

weiterlesen10 innovative Anwendungsmöglichkeiten des digitalen Fahrzeugschlüssels

13.09.2023 –

Stell dir vor, du könntest dein Auto entsperren, starten und sogar teilen, alles mit ein paar einfachen Klicks auf deinem Smartphone oder Smart Watch. Willkommen in der Zukunft der Mobilität – dank des digitalen Fahrzeugschlüssels!

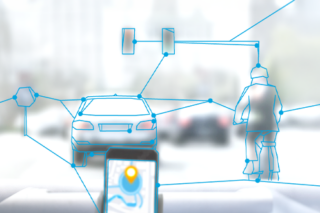

weiterlesenVehicle as a sensor: Fahrzeuge als Datenkollektoren der Zukunft – Autonomes Fahren und das enorme Potential der Bilderkennung

16.08.2023 –

Die Welt des autonomen Fahrens hat sich in den letzten Jahren rasant weiterentwickelt. Das zunehmende Interesse der Verbraucherinnen und Verbraucher für fahrerlose Autos und vor allem die prognostizierten

weiterlesen