Der Bias-Effekt im Machine Learning

Künstliche Intelligenz feierte in den letzten Jahren einen Erfolg nach dem anderen: selbstfahrende Autos oder das Entsperren von Smartphones durch Gesichtserkennung waren zum Beispiel noch vor wenigen Jahren nur in Science-Fiction-Filmen denkbar. All diese Erfolge werden durch „Machine Learning“-Methoden ermöglicht. Diese mathematischen Methoden vereinen zwei Kernaspekte:

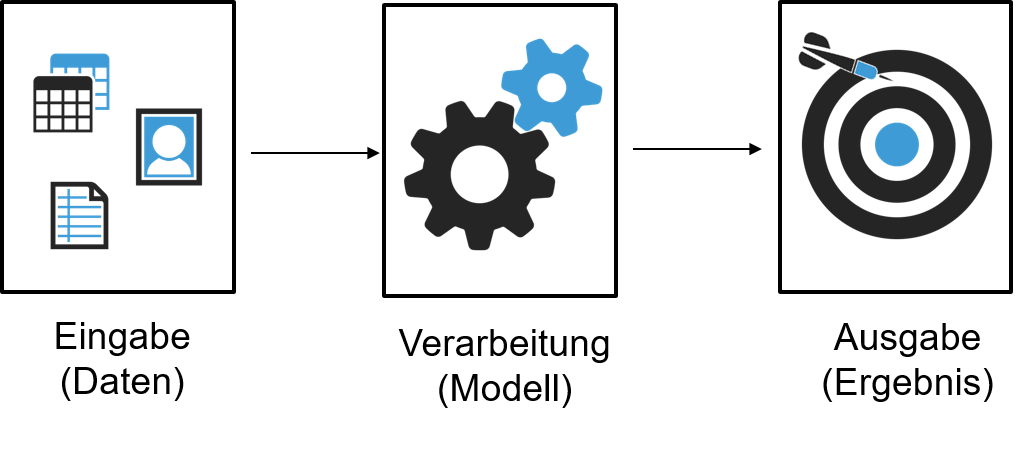

- Selbstverbesserung durch Lernen: Durch tausendfaches, gezieltes Ausprobieren wird nach der besten mathematischen Gleichung zwischen Eingangsdaten und Modellausgabe gesucht. Die gefundene und angepasste Gleichung wird dann als „Modell“ bezeichnet.

- Black Box: Während ein Ingenieur häufig mathematische Zusammenhänge auf physikalischen Prinzipien wie zum Beispiel dem Satz der Energieerhaltung aufbaut, haben Machine-Learning-Modelle diesen Anspruch nicht unbedingt. Hier ist häufig nicht genau nachvollziehbar warum ein Modell bestimmte Dinge tut und andere wiederum nicht. Genutzt wird, was funktioniert.

Bias und die Herausforderung in der Black Box

Gerade dieser „Black Box“-Aspekt vieler Machine-Learning-Verfahren macht es gar nicht so einfach zu gewährleisten, dass Modelle sich wie erwartet verhalten. Erkennt ein autonomes Auto zum Beispiel einen roten Luftballon als Stoppschild und löst eine Notbremsung aus, verhält es sich offensichtlich nicht wie gewollt.

Für solch ein Fehlverhalten des Modells kann es viele Gründe geben. Einige fallen dabei unter den englischen Begriff „Bias“. „Bias“ bedeutet dabei im Wesentlichen:

- Voreingenommenheit – je nachdem, wie wir die Welt aufgrund unserer Erfahrungen sehen kommen wir zu unterschiedlichen Schlüssen.

- Verzerrung – im statistischen Sinn als mittlere systematische Abweichung zwischen dem erwarteten („richtigen“) Modellergebnis und dem mittleren wirklich eingetretenen Modellergebnis.

Bias-Mechanismen können ganz unterschiedlicher Natur sein und vor allem an ganz unterschiedlichen Stellen in der in Abbildung 1 gezeigten, vereinfachten Machine Learning Pipeline auftreten – in den Eingangsdaten (Eingabe Daten), dem Modell selbst (Verarbeitung), oder dem Modellausgang (Ausgabe bzw. Ergebnis).

Garbage in, garbage out

Fangen wir direkt bei den Eingangsdaten an. Ein Machine Learning Modell kann nur die Zusammenhänge finden, die in den zur Verfügung gestellten Daten stecken. Soll zum Beispiel ein Produktempfehlungssystem gebaut werden, würden wir idealerweise das Kaufverhalten jedes einzelnen potentiellen Kunden messen. Das ist natürlich nicht möglich – stattdessen müssen wir uns mit dem Kaufverhalten einer Auswahl von Kunden begnügen. Die Frage ist hier: An welcher „Stelle“, bzw. für welche Kunden, wollen wir das Kaufverhalten messen?

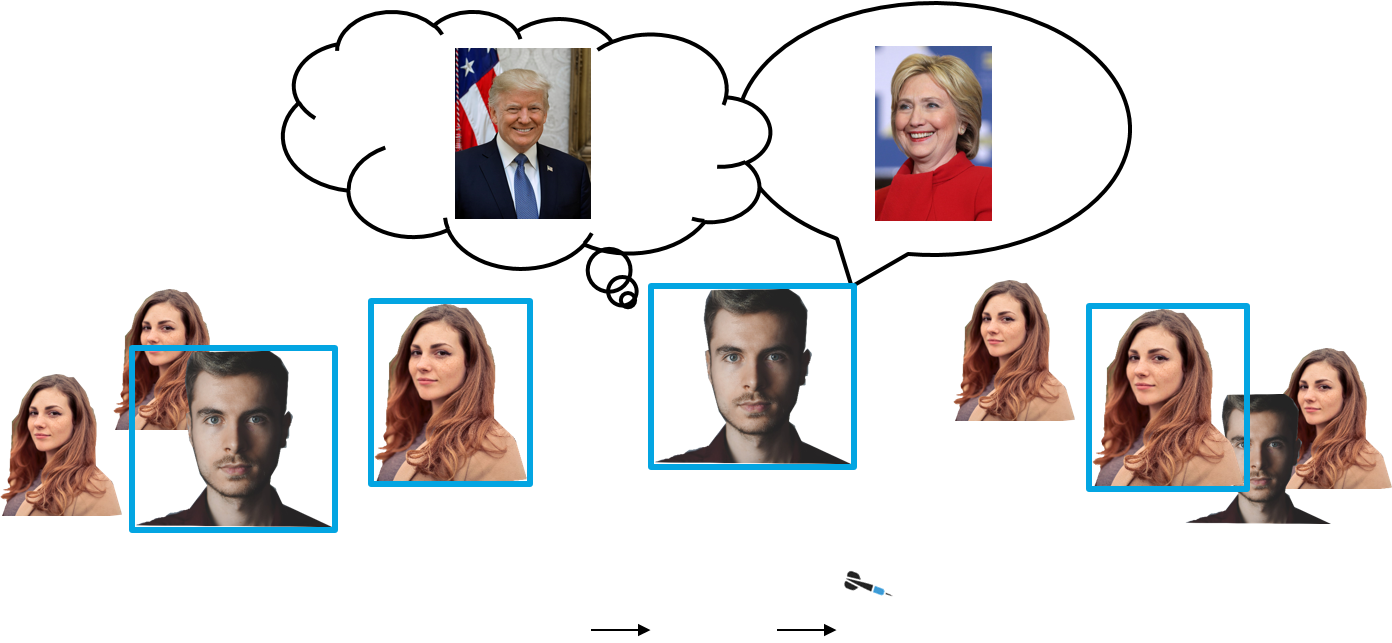

Misst man an der falschen „Stelle“ erzeugt man einen sogenannten Samplingbias. Dann sind die für das Modell ausgewählten Daten nicht repräsentativ für die Situation, in der das Modell später eingesetzt wird. Dieser Unterschied zwischen den gesammelten Daten und der realen Situation kann durch viele unterschiedliche Ursachen entstehen. Abbildung 2 illustriert ein Beispiel: Während die eigentliche Zielgruppe Männer und Frauen enthält, wurden nur die Daten von Männern gesammelt.

Dieser Effekt tritt zum Beispiel häufig auf, wenn sich Kunden für Beta-Programme aller Art bewerben können, in denen neue Produkte in kleinem Kreis getestet werden sollen. Möchte man Verhaltensdaten dieser Kunden für ein Modell nutzen, muss man aufpassen: Diese Kunden bewerben sich freiwillig (self-selection). Das können dann zum Beispiel besonders technik-affine Kunden sein oder auch besonders junge oder alte Kunden. Deren Nutzerverhalten kann sich deutlich unterscheiden von dem Nutzerverhalten der allgemeinen Kundschaft. Mit solchen verzerrten Eingangsdaten lernt das Modell falsche Zusammenhänge, die nicht das gewünschte Einsatzszenario abdecken können.

Die Kunst des Messens

Selbst wenn man die korrekten Individuen ausgewählt hat oder an der richtigen Stelle misst, ist noch lange nicht gesagt, dass man auch den korrekten Datenwert erhebt. Messungenauigkeiten kennen wir alle von physikalischen Messgeräten: sei es ein Temperaturthermometer, den Tacho im Auto oder die Uhr. Der gleiche Effekt kann auftreten, wann immer Menschen befragt werden. Wir können nicht in die Köpfe der Menschen sehen, sondern sind auf Ihre wahrheitsgemäße Antwort angewiesen. In Medikamentenstudien mag nicht jeder Proband immer die volle Wahrheit zu realer Ernährung und Medikamenteneinnahme zu Protokoll geben. Auch hier haben wir einen Messfehler vorliegen. Dieser Effekt ist auch in Abbildung 2 gezeigt: eine Person handelt später anders, als sie es in der Befragung angekündigt hat.

Eine weitere Art von Messfehlern im weiteren Sinne kann bei der Objekterkennung auftreten. Hier muss einem Machine-Learning-Algorithmus ein Satz von Bildern vorgelegt werden, auf dem zu jedem Bild bereits das korrekte Objekt („Auto“, „Motorrad“, …) markiert ist. Das Erkennen und Markieren der Objekte in den sogenannten Trainingsbildern, aus denen der Algorithmus lernen wird, ist auch heute noch ein manueller Prozess. Wenn keine einheitlichen Regeln für diesen Vorgang existieren, werden unterschiedliche Personen unterschiedliche Objekte systematisch anders markieren. Auch dieser Effekt führt dazu, dass das Modell später aus den Daten systematisch falsche Zusammenhänge lernen wird.

Voreingenommenheit der Experten

Auch Experten sind nicht gefeit vor Vorurteilen. Unterschiedliche Machine Learning Methoden eignen sich unterschiedlich gut für verschiedene Problemstellungen. Idealerweise würde man immer den perfekt zugeschnittenen Algorithmus aus seiner Werkzeugkiste nutzen. Aber natürlich hat jeder Fachexperte auch seine Vorlieben, Erfahrungen und auch äußere Einschränkungen was die verfügbaren Werkzeuge angeht. Nicht nur die Algorithmenwahl erleichtert oder erschwert die Lösung eines Problems: durch geschickte Transformationen der Problemstellung zeigen sich häufig ganz neue Lösungswege auf. Hier ist die Expertise und der Einfallsreichtum der Fachexperten gefragt, um den Bias-Effekt klein zu halten.

Der verkannte Bias-Effekt: Fairness und Vorurteile

Ein wichtiger Bias-Effekt existiert auch in direkter Bedeutung des Wortes als „Vorurteil“. Künstliche Intelligenz beeinflusst heute schon das Leben von uns allen – mehr oder weniger offensichtlich. Von der Bonitätsprüfung, zu Nachrichtenempfehlungen und sogar Kriminalitätsvorhersage. Überall können Algorithmen unser Leben entweder fördern oder uns Hindernisse in den Weg stellen.

Der Einsatz künstlicher Intelligenz macht aber ohne Zweifel viele Aktivitäten erst möglich, oder führt dazu, dass Abläufe und Prozesse erheblich optimiert werden können. Damit diese Vorteile künstlicher Intelligenz langfristig gesellschaftlich akzeptiert werden, müssen Algorithmen sich „fair“ verhalten. Ist der Algorithmus nicht fair, so urteilt er mit eingebauten Vorurteilen.

Fairness ist ein nicht eindeutig definierbarer Begriff. Je nach Zielstellung ergeben sich unter Umständen nicht auflösbare Konflikte. Bedeutet Fairness zum Beispiel, dass ähnliche Individuen gleich behandelt werden sollen – oder bedeutet Fairness, dass unterschiedliche gesellschaftliche Gruppen im Schnitt gleich behandelt werden sollen?

Unabhängig von der schlussendlichen Antwort auf diese Frage sind sie von elementarer Wichtigkeit für die Anwendung künstlicher Intelligenz. Hierzu ein Beispiel aus einer Veröffentlichung von Zhao et al. In den Weiten des Internets existiert eine Vielzahl von Bildern, die in umgebenden Text eingebettet sind.

Sehr häufig besteht ein Zusammenhang zwischen einem Bild und dem umgebenden Text: Der Text beschreibt das Bild oder das Bild illustriert den Text. Eine Aufgabe für künstliche Intelligenz kann es nun sein, zu versuchen, Bilder mit allerhand Schlagworten zu klassifizieren. Zum Beispiel für das Bild in Abbildung 4: Ort – Küche, handelnde Person – Mann.

Nutzen wir nun die Daten aus dem Internet, um unser Modell anzupassen, so fällt auf, dass nicht auf jedem zweiten Küchenbild ein Mann zu sehen ist, sondern nur auf ungefähr jedem dritten Küchenbild. Männer sind also seltener in Küchen abgebildet als Frauen. Diese Daten wurden nun genutzt, um ein Modell anzupassen. Legte man dem fertigen Modell dann aber Küchenbilder vor, so erkannte es einen Mann fälschlicherweise nur in einem von sechs Küchenbildern und nicht in einem von drei.

Fazit: Bias zeigt – KI erfordert Wissen und braucht Vertrauen

Künstliche Intelligenz kann großen Mehrwert stiften auf der einen Seite, aber sie verhält sich immer wieder in überraschender Art und Weise auf der anderen Seite. Um diese (bösen) Überraschungen zu minimieren, ist es wichtig sich mit der Methodik und den Effekten vertraut zu machen, die zu einer systematischen Verzerrung des Modellverhaltens führen. Im Englischen fallen viele dieser Effekte unter den Begriff „Bias“.

Das beinhaltet zum einen Verzerrungen im statistischen Sinne, aber gerade auch zum Beispiel Effekte wie implizite gesellschaftliche Vorurteile.

Das heißt, künstliche Intelligenz kann dazu führen, dass bereits existierende Vorurteile durch den Algorithmus noch verfestigt werden. So tritt ein selbstverstärkender Effekt ein.

Fairness für künstliche Intelligenz ist ein aktuelles Forschungsthema. Es gibt zahlreiche Methoden, um diese Effekte abzuschwächen und zu verhindern, aber auch hier gilt: Erst wenn diese Effekte bekannt sind, können diese auch angegangen und behoben werden. Um das gesellschaftliche Vertrauen in Künstliche Intelligenz zu stärken, ist es besonders wichtig gerade diese Effekte zu verstehen und ihnen aktiv entgegenzuwirken.

Dieser Blogbeitrag könnten Dich auch interessieren: Die fünf ultimativen KI Trends für das nächste Jahrzehnt

Quellen

Zhao et al. „Men also like shopping: Reducing gender bias amplification using corpus-level constraints.“ arXiv preprint arXiv:1707.09457 (2017).

Abbildung 2: Mann: https://www.pexels.com/photo/face-facial-hair-fine-looking-guy-614810/ Frau: https://www.pexels.com/photo/closeup-photo-of-woman-with-brown-coat-and-gray-top-733872/ Lizenz pexels: https://www.pexels.com/photo-license

Abbildung 3: Mann: https://www.pexels.com/photo/face-facial-hair-fine-looking-guy-614810/ Frau: https://www.pexels.com/photo/closeup-photo-of-woman-with-brown-coat-and-gray-top-733872/ Lizenz pexels: https://www.pexels.com/photo-license Trump: https://commons.wikimedia.org/wiki/File:Donald_Trump_official_portrait_(cropped).jpg Lizenz: Public Domain https://commons.wikimedia.org/wiki/File:Hillary_Clinton_by_Gage_Skidmore_2.jpg Lizenz by Gage Skidmore, CC BY-SA 3.0, https://commons.wikimedia.org/w/index.php?curid=46897599

Abbildung 4: „Cooks being trained at the École supérieure de cuisine française in Paris“, David Monniaux, https://de.wikipedia.org/wiki/Kochen#/media/File:Cooks_050918_154402.jpg , Lizenz: CC BY-SA 3.0 (https://creativecommons.org/licenses/by-sa/3.0/deed.en)

Diese weiteren Blogbeiträge könnten auch interessant sein:

Wie starte ich ein Machine Learning Projekt

Mit Machine Learning das Potenzial aus Daten nutzen

Technische Umsetzung von Machine Learning Lösungen mit Spark MLIib

Spannender Artikel! Hab jetzt auf jeden fall einen anderen Blick auf das Thema.